HF关于采样策略的实现

- 参考:top_k_top_p_filtering (老版本)

- 参考:

- src/transformers/generation/logits_process.py

- TopPLogitsWarper

- TopKLogitsWarper

- src/transformers/generation/utils.py

- _get_logits_processor

- 先topk,再topp

- _get_logits_processor

- src/transformers/generation/logits_process.py

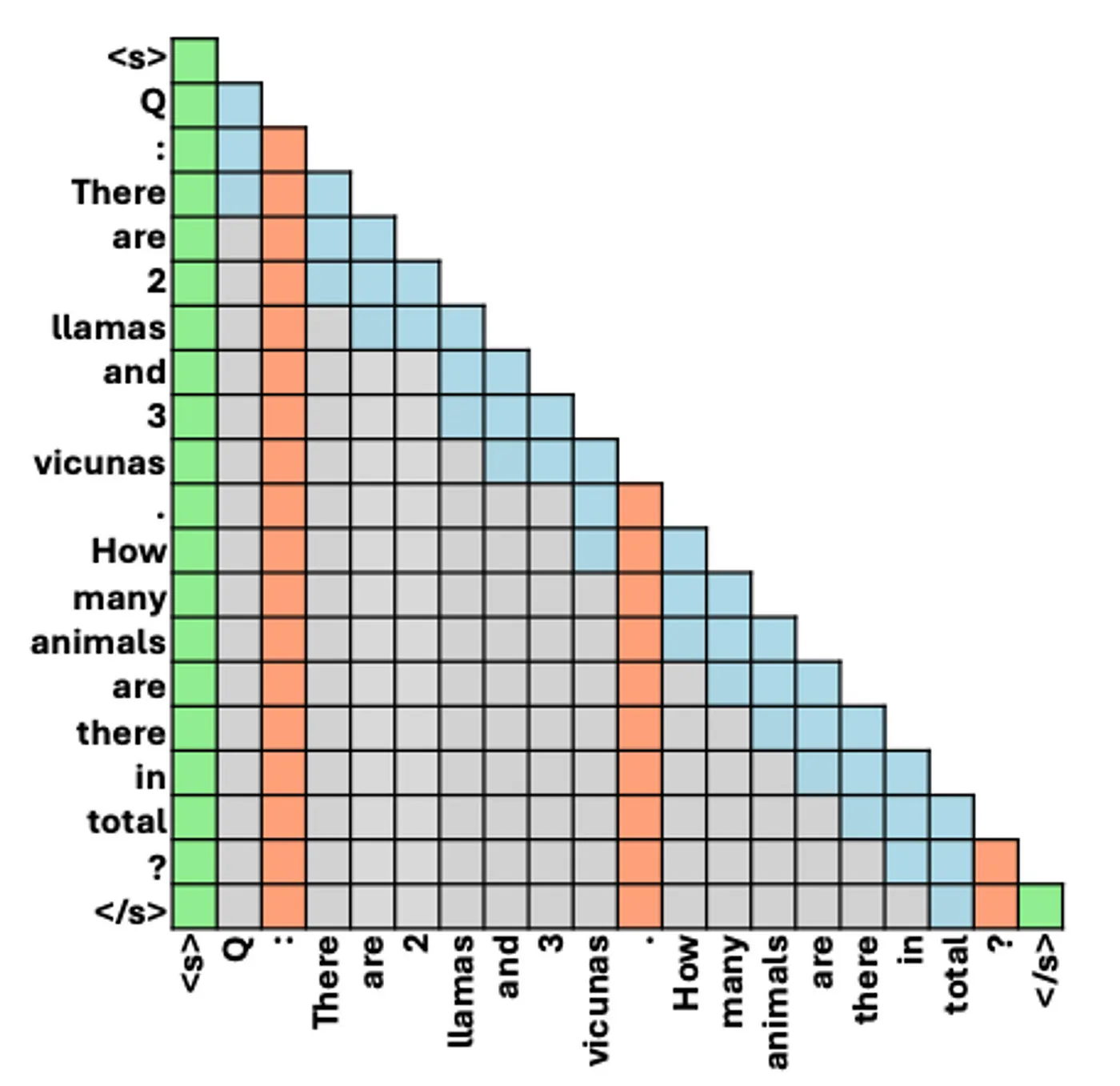

LLM推理之两大阶段

- 基于LLM自回归生成(autoregressive generation)的特点

- 逐token生成,生成的token依赖于前面的token

- 一次只能生成一个token,无法同时生成多个token

- LLM生成过程分为两个阶段

- Prefill phase

- Decoding phase

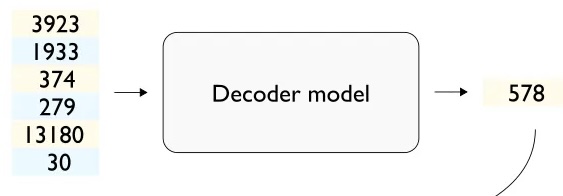

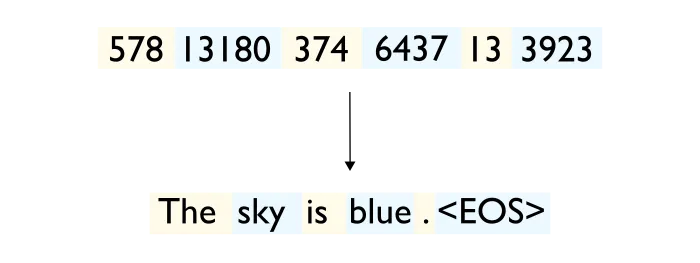

LLM推理第一阶段: Prefill

输入token序列,输出下一个token

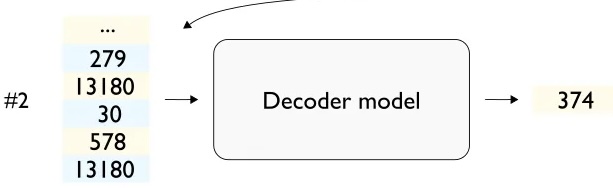

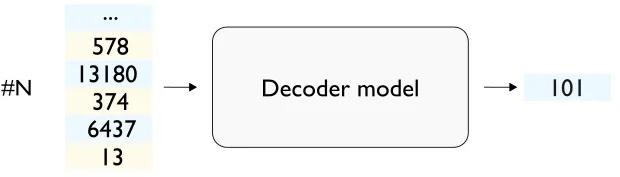

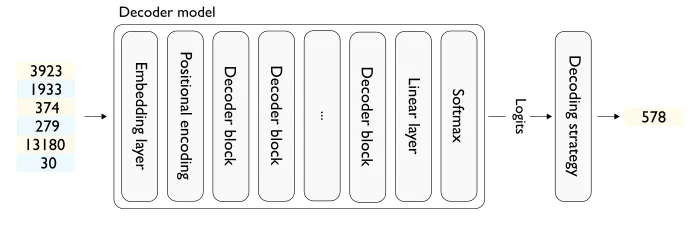

LLM推理第二阶段: Decoding

LLM推理第二阶段: Decoding

LLM完成推理后,解码

将生成的token序列解码成文本

LLM二阶段推理解析

- 将LLM当作函数,输入是token序列,输出是下一个token

- LLM通过自回归(autoregressive generation)不断生成"下一个token"

- 脑补下当LLM接收到输入的token序列后如何进行下一个token的推理

LLM推理过程会产生一些中间变量

第一个"下一个token"生成: 输入token序列"经过"(调用forward方法)N层Decoder layer后,的到结果

细看其中一层Decoder layer,frward方法会返回若干中间输出,被称之为激活(activation)

Prefill phase

- 第一个"下一个token"生成过程被称之为Prefill阶段

- 为何特殊对待?

- 计算开销大

- 简单推导一下一次LLM的推理过程的计算开销

计算开销

- 符号约定

- b: batch size

- s: sequence length

- h: hidden size/dimension

- nh: number of heads

- hd: head dimension

计算开销

- 给定矩阵

- FLOPs: floating point operations

- 给定矩阵

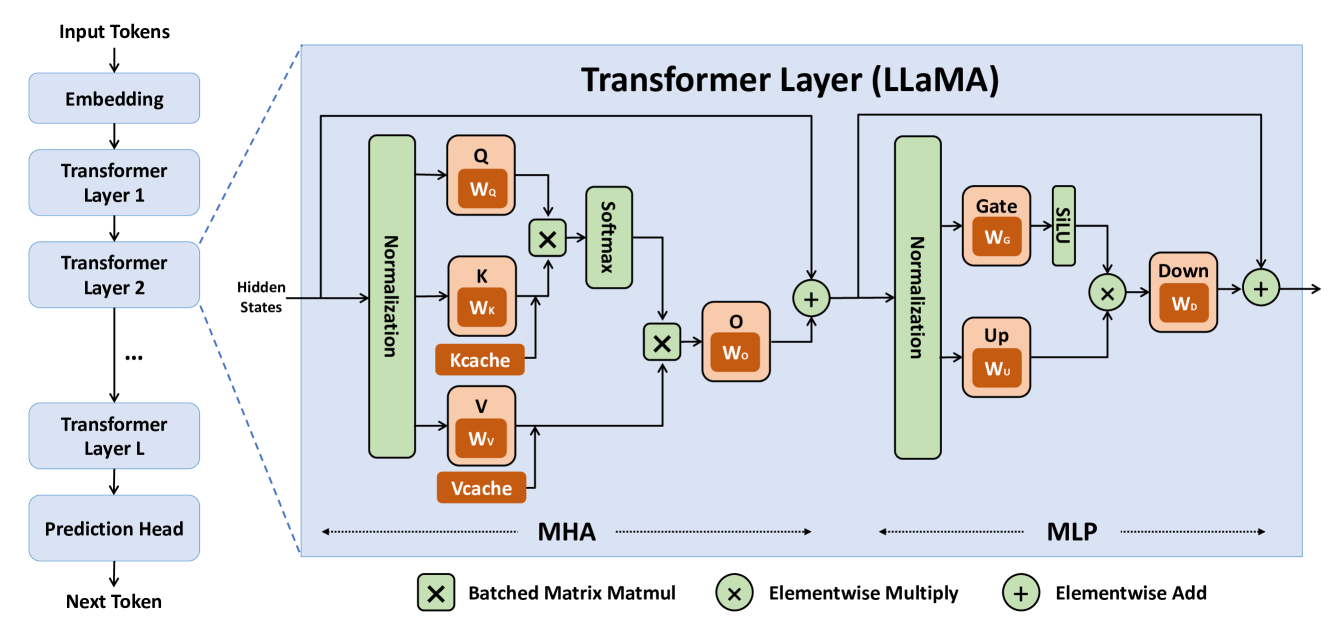

Self-attn模块

- 第一步计算:

- 输入x的shape:

- Shape视角下的计算过程:

- 如果在此进行多头拆分(reshape/view/einops),shape变为

- 如果在此进行多头拆分(reshape/view/einops),shape变为

- 计算开销:

- 输入x的shape:

Self-attn模块

- 第二步计算:

- 计算开销:

- 计算开销:

- 计算开销:

- 计算开销:

- 第三步

- 计算开销:

- 计算开销:

- Self-attn模块总计算开销:

MLP模块

- 第一步计算,假设上采样到4倍

- Shape变化:

- 计算开销:

- Shape变化:

- 第二步计算,假设下采样回1倍

- Shape变化:

- 计算开销:

- Shape变化:

- MLP模块总计算开销:

Decoder layer模块计算开销

-

Self-attn模块计算开销:

-

MLP模块计算开销:

-

Decoder layer模块计算开销:

-

以上为一次推理的计算开销,开销为sequence的平方级别

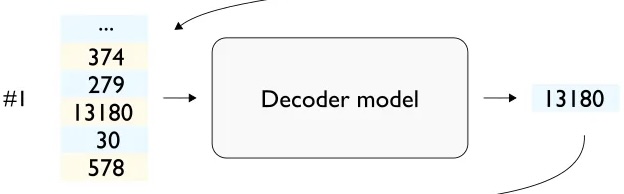

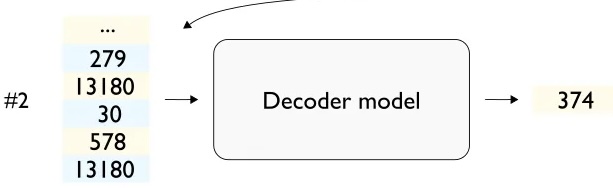

Decoding phase

- 当第一个"下一个token"生成完毕后,LLM开始"自回归推理"生成

- 第二个"下一个token"

- 输入x的shape:

- 输入x的shape:

- 第三个"下一个token"

- 输入x的shape:

- 输入x的shape:

- 第n个"下一个token"

- 输入x的shape:

- 输入x的shape:

- 自回归推理过程的计算开销

- 每次自回归推理过程,都需要平方级别的开销?

- 且包含了计算开销和内存开销

回顾Self-attn中

- 第一个"下一个token"

- 第二个"下一个token"

- 考虑自回归特性,

- 考虑复用

LLM自回归过程中的复用

- 要复用什么,还得从需求出发

- 需求: 生成"下一个token"

- Decoder layers之后的lm_head计算

- shape视角:

- shape视角:

- 生成第二个"下一个token"

- shape视角:

- 第二个"下一个token"的logits在

- shape视角:

LLM自回归过程中的复用

- 真正要复用的是用于计算

- shape的视角:

- shape的视角:

- 整个self-attn计算过程中,只有

- 为K和V构建缓存: 即KVCache

Self-attn例